客户端开发

构建 MCP 客户端

开始构建您自己的客户端,以便与所有 MCP 服务器集成。

在本教程中,您将学习如何构建一个由 LLM 驱动的聊天机器人客户端,并将其连接到 MCP 服务器。建议您先完成服务器快速入门,该指南将引导您了解构建第一个服务器的基础知识。

您可以在这里找到本教程的完整代码。将您的密钥添加到 将 您可以在这里找到完整的 客户端将

系统要求

开始之前,请确保您的系统满足以下要求- Mac 或 Windows 计算机

- 已安装最新 Python 版本

- 已安装最新版本的

uv

设置您的环境

首先,使用uv 创建一个新的 Python 项目设置您的 API 密钥

您需要从 Anthropic 控制台获取一个 Anthropic API 密钥。创建一个.env 文件来存储它:.env 文件中.env 添加到您的 .gitignore 中请确保您的

ANTHROPIC_API_KEY 安全!创建客户端

基本客户端结构

首先,让我们设置导入并创建基本的客户端类服务器连接管理

接下来,我们将实现连接到 MCP 服务器的方法查询处理逻辑

现在让我们添加处理查询和工具调用的核心功能交互式聊天界面

现在我们将添加聊天循环和清理功能主入口点

最后,我们将添加主执行逻辑client.py 文件。关键组件说明

1. 客户端初始化

MCPClient类通过会话管理和 API 客户端进行初始化- 使用

AsyncExitStack进行适当的资源管理 - 配置 Anthropic 客户端以进行 Claude 交互

2. 服务器连接

- 支持 Python 和 Node.js 服务器

- 验证服务器脚本类型

- 设置适当的通信渠道

- 初始化会话并列出可用工具

3. 查询处理

- 维护对话上下文

- 处理 Claude 的响应和工具调用

- 管理 Claude 与工具之间的消息流

- 将结果整合成连贯的响应

4. 交互式界面

- 提供简单的命令行界面

- 处理用户输入并显示响应

- 包含基本的错误处理

- 允许优雅退出

5. 资源管理

- 妥善清理资源

- 处理连接问题的错误

- 优雅的关闭程序

常见自定义点

-

工具处理

- 修改

process_query()以处理特定工具类型 - 为工具调用添加自定义错误处理

- 实现特定于工具的响应格式化

- 修改

-

响应处理

- 自定义工具结果的格式化方式

- 添加响应过滤或转换

- 实现自定义日志记录

-

用户界面

- 添加 GUI 或 Web 界面

- 实现富文本控制台输出

- 添加命令历史或自动补全功能

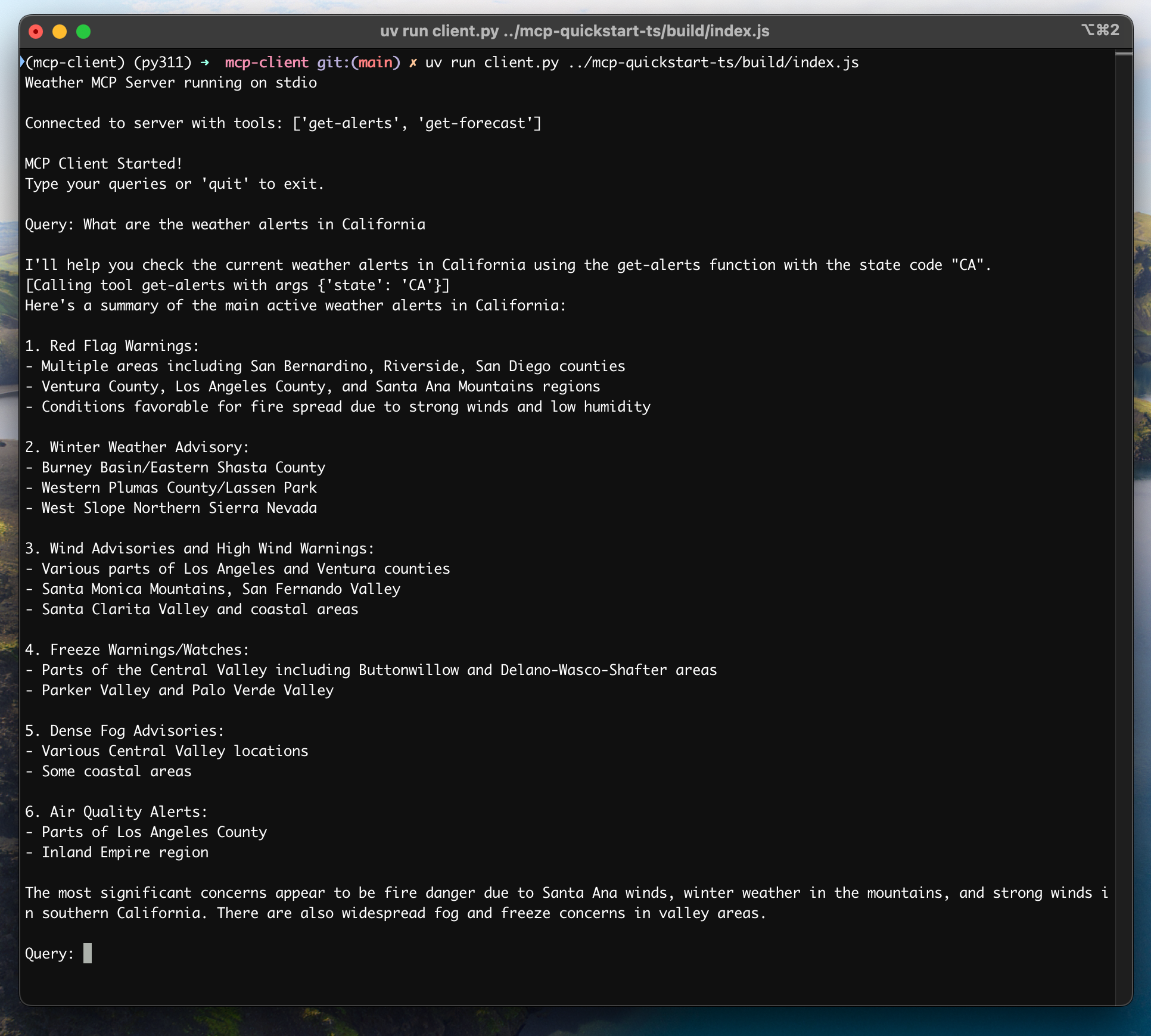

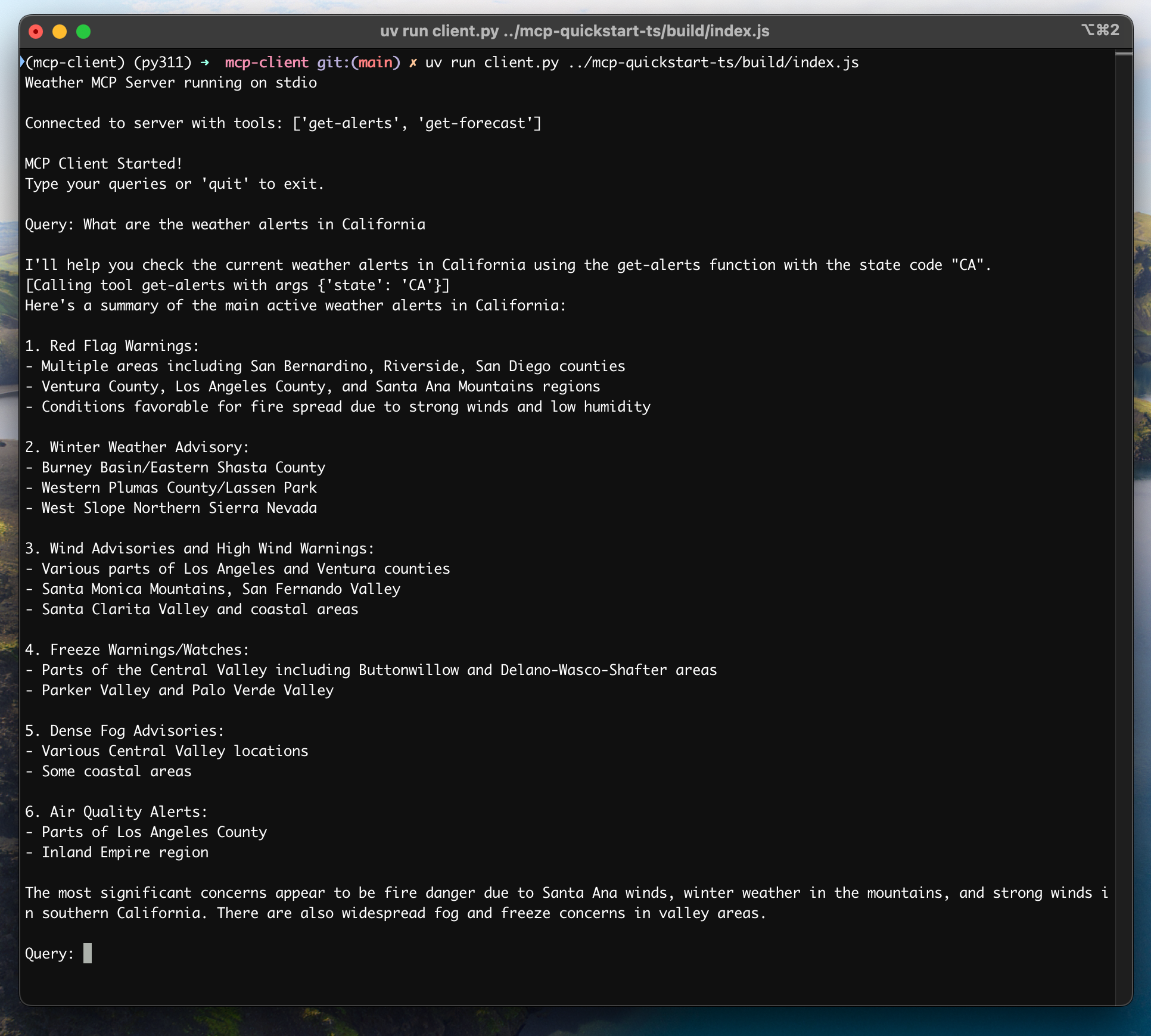

运行客户端

要使用任何 MCP 服务器运行您的客户端如果您正在继续服务器快速入门中的天气教程,您的命令可能类似于这样:

python client.py .../quickstart-resources/weather-server-python/weather.py- 连接到指定的服务器

- 列出可用的工具

- 启动一个交互式聊天会话,您可以在其中

- 输入查询

- 查看工具执行情况

- 获取来自 Claude 的响应

工作原理

当您提交查询时- 客户端从服务器获取可用工具列表

- 您的查询连同工具描述一起发送给 Claude

- Claude 决定使用哪些工具(如果有的话)

- 客户端通过服务器执行任何请求的工具调用

- 结果被发送回 Claude

- Claude 提供自然语言响应

- 响应将显示给您

最佳实践

-

错误处理

- 始终将工具调用包装在 try-catch 块中

- 提供有意义的错误消息

- 优雅地处理连接问题

-

资源管理

- 使用

AsyncExitStack进行妥善清理 - 完成后关闭连接

- 处理服务器断开连接的情况

- 使用

-

安全

- 将 API 密钥安全地存储在

.env中 - 验证服务器响应

- 谨慎对待工具权限

- 将 API 密钥安全地存储在

故障排除

服务器路径问题

- 仔细检查您的服务器脚本路径是否正确

- 如果相对路径无效,请使用绝对路径

- 对于 Windows 用户,请确保在路径中使用正斜杠 (/) 或转义的反斜杠 (\\)

- 验证服务器文件是否具有正确的扩展名(Python 为 .py,Node.js 为 .js)

响应时间

- 第一次响应可能需要长达 30 秒才能返回

- 这是正常现象,发生在以下情况时

- 服务器正在初始化

- Claude 正在处理查询

- 工具正在被执行

- 后续响应通常会更快

- 在此初始等待期间不要中断进程

常见错误消息

如果您看到FileNotFoundError: 检查您的服务器路径Connection refused: 确保服务器正在运行且路径正确Tool execution failed: 验证工具所需的环境变量是否已设置Timeout error: 考虑在您的客户端配置中增加超时时间